在这周二,meta发布了最新的ai模型llama 3.1,并且是一个开源模型,面向公众免费提供,且提供8b、70b、305b参数版本,模型整体效果可与 gpt-4、gpt-4o、claude 3.5 sonnet 等领先的闭源模型相媲美。

此次llama 3.1 系列改进了推理能力及多语言支持,上下文长度提升至 128k,并且首次推出 405b 参数的旗舰模型。llama 3.1 405b 是首个在常识、可操纵能力、数学、工具使用和多语种翻译等方面媲美顶级闭源人工智能模型的公开发布的模型。

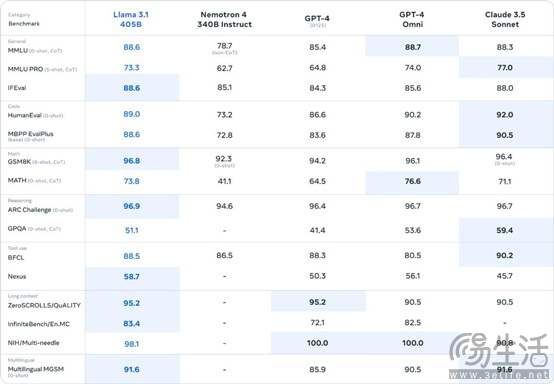

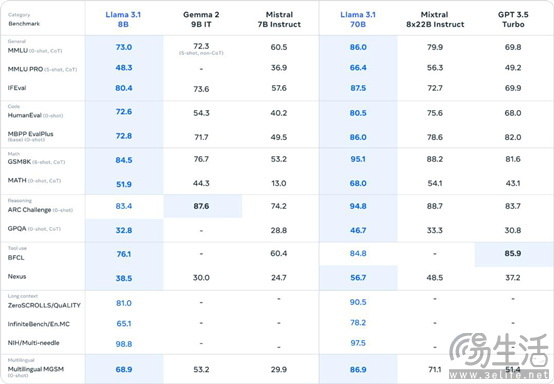

在llama 3.1 405b与其他模型的对比中,llama 3.1 405b在任务测试中基本是媲美闭源的大语言模型,而小型模型在各种测试中也是优于其他模型,无论是企业还是个人用户,llama 3.1似乎都成了不错的选择。

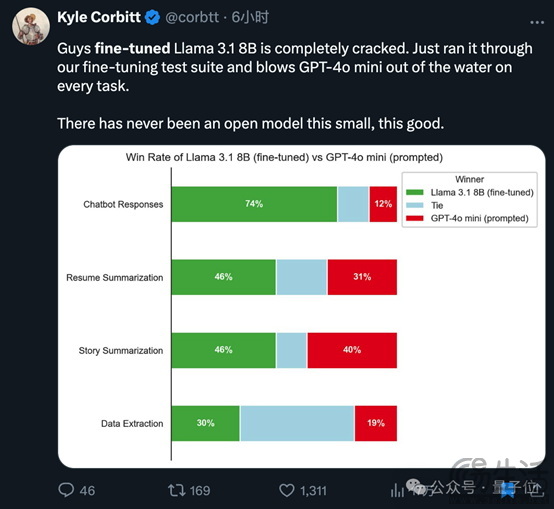

而llama 3.1的8b小模型在聊天、总结、信息提取任务上要比其他小模型强上一些,在网友分享的测试中,对比gpt-4o mini 提示词,llama 3.1 8b的表现最优,至少针对个人用户,现在开源的llama 3.1 8b是一个不错的选择。

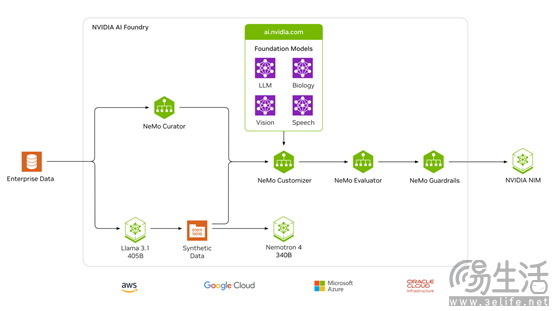

除了meta公布开源模型外,英伟达还宣布推出全新 nvidia ai foundry 代工服务和 nvidia nim™ 推理微服务,其中nvidia ai foundry 已经在整个过程中集成了 llama 3.1,结合英伟达的软件、计算和专业知识,能够帮助企业构建和部署自定义 llama 超级模型。

也就是说,在nvidia ai foundry,用户可以结合结合数据,使用llama 3.1 405b 和 nvidia nemotron™ reward 模型共同生成的数据来训练自己的模型,而这也是llama 3.1开源协议内允许的,但这些模型名称需要加入llama的字样。

从nvidia ai foundry输出结果则由 nvidia nim(一个推理微服务,其中包括定制模型、优化引擎和标准 api)负责,可以部署到任何地方,包括云计算、数据中心、工作站、pc等,可以高效地协调和管理容器化人工智能应用。

那么个人用户想要本地运行llama 3.1模型,则需要选择8b模型,内存上需要32gb以上最好,同时显卡显存越大越好,最低至少8gb,但显卡的显存大小会影响速度,其中16gb显存的显卡也可以使用70b的模型,但吐字速度会比较慢,但也要比无法使用要强,因此拥有一张影驰rtx 4070 ti super 星曜oc显卡,是入门大语言模型ai的最优选。

影驰rtx 4070 ti super 星曜oc,采用nvidia ada lovelace架构,拥有16gb的显存容量,相比4070显卡要多出4gb显存,刚好可以入门一些ai应用,比如上文所说的llama 3.1 8b模型,以及stable diffusion ai绘画等,是一张想完整体验ai时需要的好伙伴,感兴趣的朋友可以前往官方商城选购~